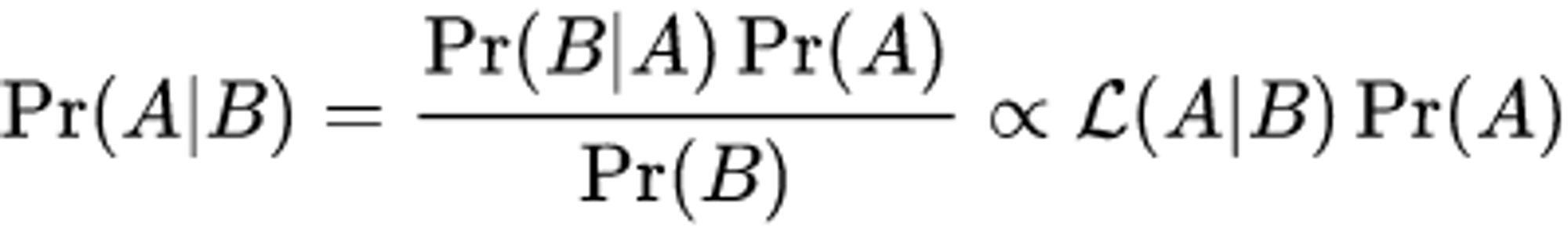

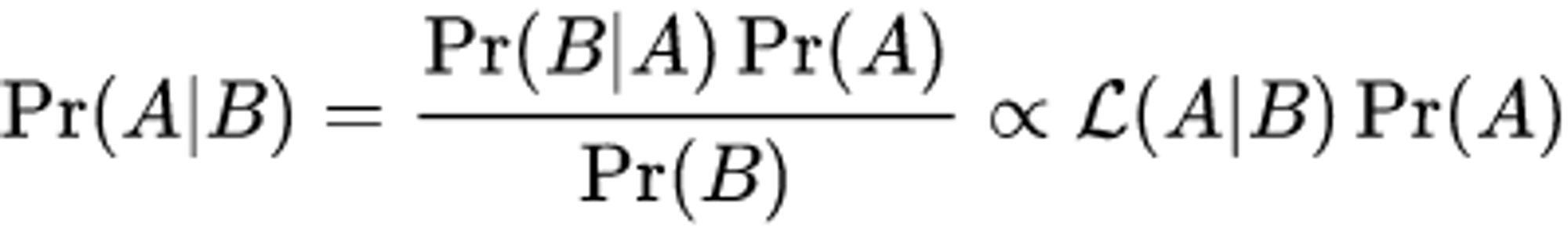

위키 피디아의 Bayes' theorem 정리

Pr(A) : 사건 A 의 Prior 사전 확률, 사건 B에 대해 아무 정보가 없음을 의미

Pr(B) : 사건 B 의 Prior 사전 확률

Pr(A|B) : B의 값이 주어졌을 때 A의 Posterior 사후 확률

Pr(B|A) : likelihood

**** Potsterior 와 Likelihood 는 식에서의 위치에 따라 값이 달라질 수 있다.**

딥러닝에서의 Bayes’ Rule

보통 딥러닝에서 Potsterior 는 구하고싶은 값으로 사용되고 Likelihood 는 Loss (NLL, MLE) 로 사용된다.

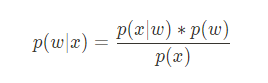

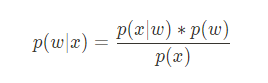

주어진 입력이 x 이고, 모델 파라미터를 w 라고 할때 데이터 x에 대한 predicted y 값을 잘 예측하도록 모델 파라미터를 학습시키고 싶을 때

posterior 는 밑과 같다 : 데이터 x 가 주어졌을 때 weight 에 대한 probability 이다.

근데 어떤 모델 파라미터가 적합한지를 몰라서 p(w|x)를 얻는다고 하더라도 그에 대한 평가를 내릴 수가 없다.

그래서 그 대신에 사용하는 방법이 p(x|w) likelihood 를 맞추는 방법인 것이다.

p(x|w)(likelihood) 는 weight 가 주어졌을 때 input x 의 prob → 모델 inference output

즉, 인풋 데이터 x 를 정해진 w 의 네트워크에 적용했을 때의 output 을 말한다.

⇒ 근데, class 중에서 맞는 class의 prob 이므로 → maximize(최대화) 해야하는 것이다

Cross Entropy Loss Minimization 도 MLE 의 방법론 중 하나이다.

likelihood(가능도) 를 최대화하는 이유는 posterior 도 커지기 때문에.

Bayes 법칙 : Hypothesis

같은 식으로 W 대신 H(x) =Wx + b hypothesis 를 사용하기도 한다.

Hypothesis 는 모델 자체를 의미한다.

'머신러닝 이모저모' 카테고리의 다른 글

| Precision 개념 (0) | 2024.02.18 |

|---|---|

| VScode 에서 tmux 사용하기 (0) | 2024.01.03 |

| UserWarning: CUDA initialization: Unexpected error from cudaGetDeviceCount() 에러 처리 (0) | 2024.01.03 |

| GPT-2 를 seq2seq 방식으로 학습시키기 (0) | 2023.12.07 |

| Ensemble (앙상블 기법) (0) | 2023.09.08 |

위키 피디아의 Bayes' theorem 정리

Pr(A) : 사건 A 의 Prior 사전 확률, 사건 B에 대해 아무 정보가 없음을 의미

Pr(B) : 사건 B 의 Prior 사전 확률

Pr(A|B) : B의 값이 주어졌을 때 A의 Posterior 사후 확률

Pr(B|A) : likelihood

**** Potsterior 와 Likelihood 는 식에서의 위치에 따라 값이 달라질 수 있다.**

딥러닝에서의 Bayes’ Rule

보통 딥러닝에서 Potsterior 는 구하고싶은 값으로 사용되고 Likelihood 는 Loss (NLL, MLE) 로 사용된다.

주어진 입력이 x 이고, 모델 파라미터를 w 라고 할때 데이터 x에 대한 predicted y 값을 잘 예측하도록 모델 파라미터를 학습시키고 싶을 때

posterior 는 밑과 같다 : 데이터 x 가 주어졌을 때 weight 에 대한 probability 이다.

근데 어떤 모델 파라미터가 적합한지를 몰라서 p(w|x)를 얻는다고 하더라도 그에 대한 평가를 내릴 수가 없다.

그래서 그 대신에 사용하는 방법이 p(x|w) likelihood 를 맞추는 방법인 것이다.

p(x|w)(likelihood) 는 weight 가 주어졌을 때 input x 의 prob → 모델 inference output

즉, 인풋 데이터 x 를 정해진 w 의 네트워크에 적용했을 때의 output 을 말한다.

⇒ 근데, class 중에서 맞는 class의 prob 이므로 → maximize(최대화) 해야하는 것이다

Cross Entropy Loss Minimization 도 MLE 의 방법론 중 하나이다.

likelihood(가능도) 를 최대화하는 이유는 posterior 도 커지기 때문에.

Bayes 법칙 : Hypothesis

같은 식으로 W 대신 H(x) =Wx + b hypothesis 를 사용하기도 한다.

Hypothesis 는 모델 자체를 의미한다.

'머신러닝 이모저모' 카테고리의 다른 글

| Precision 개념 (0) | 2024.02.18 |

|---|---|

| VScode 에서 tmux 사용하기 (0) | 2024.01.03 |

| UserWarning: CUDA initialization: Unexpected error from cudaGetDeviceCount() 에러 처리 (0) | 2024.01.03 |

| GPT-2 를 seq2seq 방식으로 학습시키기 (0) | 2023.12.07 |

| Ensemble (앙상블 기법) (0) | 2023.09.08 |